Il mondo digitale è in continua evoluzione e un catalizzatore che differenzia questa piattaforma dalle altre lo è contenuti generati dagli utenti. Sebbene le aziende di tutto il mondo abbiano i loro siti Web e una presenza sui social media dedicata, è più probabile che gli utenti si fidino delle opinioni dei loro colleghi clienti piuttosto che seguire le parole dell'azienda.

Più di 4.26 miliardi di persone erano utenti attivi dei social media nel 2021. Si prevede che un numero raggiungerà i 6 miliardi entro il 2027. La quantità di contenuti generati, acquisiti, condivisi e consumati su scala globale ha toccato i 64.2 zettabyte nel 2020.

Con la generazione e il consumo di nuovi contenuti a un ritmo sbalorditivo, è diventato essenziale che i marchi tengano d'occhio i contenuti ospitati sulle loro piattaforme. Piattaforme online dovrebbe essere e rimanere un ambiente sicuro per i suoi utenti.

[Leggi anche: Comprendere la moderazione automatizzata dei contenuti]

Che cos'è la moderazione dei contenuti e perché?

I contenuti generati dagli utenti spingono le piattaforme di social media e moderazione dei contenuti si riferisce allo screening di questo contenuto per post inappropriati o offensivi. Le piattaforme aziendali e di social media hanno uno standard specifico per il monitoraggio dei loro contenuti di hosting.

Le linee guida potrebbero includere qualsiasi cosa, dalla violenza, all'estremismo, incitamento all'odio, nudità, violazione del copyright o qualsiasi cosa offensiva. Il contenuto pubblicato verrà contrassegnato e rimosso se non soddisfa lo standard.

L'idea alla base della moderazione dei contenuti è garantire che i contenuti siano in sintonia con gli ideali del marchio e sostengano i valori di decenza, fiducia e sicurezza.

La moderazione dei contenuti è fondamentale per le aziende per mantenere gli standard aziendali, l'immagine del marchio, la reputazione e la credibilità. Ogni secondo, l'incredibile quantità di contenuti generati dagli utenti pubblicati sulle piattaforme rende difficile per i marchi tenersi fuori dall'offensiva e contenuto inappropriato, testo, video e immagini. La strategia di moderazione dei contenuti aiuta i marchi a mantenere la propria immagine consentendo agli utenti di esprimersi e chiudendo i contenuti offensivi, espliciti e violenti.

Quali tipi di contenuti puoi moderare?

Gli algoritmi di moderazione dei contenuti generalmente gestiscono tre o una combinazione di questi tipi di contenuto.

Testo

L'enorme quantità di testo, dai commenti agli articoli interi, che necessita di moderazione è piuttosto sbalorditiva. I post di testo sono disponibili quasi ovunque sotto forma di commenti, articoli, post sul forum, discussioni sui social media e altri post.

Gli algoritmi di moderazione del contenuto del testo dovrebbero essere in grado di scansionare il testo di diverse lunghezze e stili alla ricerca di contenuti indesiderati. Inoltre, la moderazione del testo può essere un compito difficile a causa della complessità della lingua e delle sfumature culturali.

Immagini

La moderazione delle immagini è molto più semplice della moderazione del testo, ma è essenziale disporre di linee guida o standard adeguati.

Inoltre, poiché durante la moderazione delle immagini possono entrare in gioco differenze culturali, è fondamentale comprendere a fondo e connettersi con la comunità di utenti in diverse località geografiche.

Video

La moderazione dei contenuti video è molto difficile, poiché la moderazione dei video può richiedere molto tempo, a differenza del testo o delle immagini. Il moderatore deve guardare l'intero video prima di ritenerlo idoneo o non idoneo al consumo. Anche se solo alcuni fotogrammi del video sono espliciti o disturbanti, costringerà il moderatore a rimuovere l'intero contenuto.

Diretta streaming

Il live streaming è, forse, il contenuto più difficile da moderare. È perché la moderazione del video e del testo di accompagnamento deve avvenire contemporaneamente allo streaming.

Come funziona la moderazione dei contenuti?

Per iniziare a moderare i contenuti sulla tua piattaforma, dovresti prima mettere in atto standard o linee guida che determinino contenuti inappropriati. Queste linee guida aiutano i moderatori a segnalare i contenuti per la rimozione.

Definire il livello di sensibilità o la soglia che i moderatori del contenuto dovrebbero considerare durante la revisione del contenuto. La soglia dovrebbe essere definita in base al tuo marchio, al tipo di attività, alle aspettative degli utenti e alla posizione.

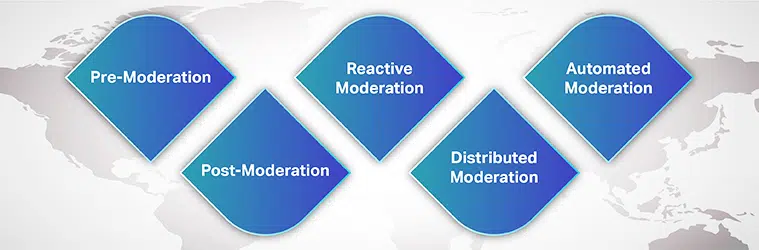

Tipi di moderazione dei contenuti

Puoi scegliere tra tanti processi di moderazione per le esigenze del tuo marchio e consenso dell'utente. Alcuni di loro sono:

Pre-moderazione

Prima che il contenuto venga visualizzato sul tuo sito, è in coda per la moderazione. Solo dopo che il contenuto è stato esaminato e ritenuto idoneo al consumo viene pubblicato sulla piattaforma. Sebbene questo sia un metodo sicuro per bloccare il contenuto esplicito, richiede molto tempo.

Post moderazione

La post-moderazione è il metodo standard di moderazione dei contenuti in cui esiste un compromesso tra coinvolgimento degli utenti e moderazione. Sebbene gli utenti siano autorizzati a pubblicare i propri invii, sono comunque in coda per la moderazione. Se il contenuto è stato segnalato, viene esaminato e rimosso. Le aziende si sforzano di ottenere un tempo di revisione più breve in modo che i contenuti inappropriati non possano rimanere online troppo a lungo.

Moderazione reattiva

Con moderazione reattiva, la comunità degli utenti è incoraggiata a segnalare i contenuti inappropriati che violano la comunità regole e linee guida. In questo metodo, l'attenzione della comunità è attirata sul contenuto che necessita di moderazione. Tuttavia, il contenuto offensivo potrebbe rimanere sulla piattaforma per periodi più lunghi.

Moderazione distribuita

In un metodo di moderazione distribuita, la comunità online può rivedere, contrassegnare e rimuovere i contenuti che ritengono offensivi e contrari alle linee guida utilizzando un sistema di classificazione.

Moderazione automatizzata

Come suggerisce il nome, la moderazione automatizzata utilizza vari strumenti e sistemi per contrassegnare parole o frasi e rifiutare gli invii. Funziona filtrando alcune parole, immagini e video vietati utilizzando algoritmi di apprendimento automatico.

Sebbene la moderazione basata sulla tecnologia stia diventando prevalente, moderazione umana in revisione non può essere ignorato. Le aziende, idealmente, utilizzano una combinazione di strumenti automatizzati e moderatori umani, almeno per situazioni complesse.

[Leggi anche: Caso di studio – Moderazione dei contenuti]

In che modo Machine Learning aiuta la moderazione dei contenuti?

Con più di 5 miliardi di persone che utilizzano Internet e oltre 4 miliardi di persone attive sui social network, non è facile rimanere stupiti dal numero di immagini, testi, video, post e messaggi generati quotidianamente. Questo contenuto gigantesco deve essere moderato in qualche modo in modo che gli utenti che accedono ai loro siti di social media possano vivere un'esperienza piacevole e arricchente.

La moderazione dei contenuti è nata come soluzione per rimuovere contenuti espliciti, offensivi, offensivi, truffatori o contrari all'etica del marchio. Tradizionalmente, le aziende si sono affidate interamente a moderatori umani per rivedere i contenuti online generati dagli utenti pubblicati sulle loro piattaforme. Tuttavia, dipendere interamente dai moderatori umani può rendere il processo dispendioso in termini di tempo, costoso e inefficiente.

Le aziende stanno ora utilizzando algoritmi di apprendimento automatico per moderare i contenuti in modo automatico ed efficiente. AI-alimentato la moderazione dei contenuti ha reso l'intero processo efficiente, più veloce, coerente e conveniente.

Sebbene questo processo non elimini la necessità di moderatori umani – umano-in-the-loop, il contributo dei moderatori umani aiuta ad affrontare questioni complesse. Inoltre, i moderatori umani comprendono meglio le sfumature linguistiche, le differenze culturali e il contesto. Quando vengono utilizzati strumenti automatizzati, con l'aiuto di moderatori umani, si riduce l'impatto psicologico dell'esposizione al contenuto attivato.

Sfide della moderazione dei contenuti

Un'altra sfida importante quando si tratta di sviluppare un algoritmo di moderazione dei contenuti accurato è il linguaggio. Un'applicazione affidabile di moderazione dei contenuti dovrebbe essere in grado di riconoscere diverse lingue e comprendere le sfumature culturali, i contesti sociali e il dinamismo linguistico.

Dal momento che una lingua subisce diversi cambiamenti nel tempo, poiché alcune parole che ieri erano innocenti avrebbero potuto guadagnare notorietà oggi, il modello ML deve stare al passo con il mondo che cambia. Ad esempio, un dipinto di nudo potrebbe essere esplicito e voyeuristico o semplicemente arte.

Come a contenuto è percepito o ritenuto inappropriato dipende dal contesto. Ed è fondamentale avere coerenza e standard all'interno della tua piattaforma in modo che i tuoi utenti possano fidarsi dei tuoi sforzi di moderazione.

Un utente tipico cerca sempre di trovare scappatoie nelle linee guida e aggirare le regole di moderazione. Tuttavia, il tuo algoritmo ML dovrebbe essere in grado di evolversi continuamente con i tempi che cambiano.

Infine, è la questione del pregiudizio. È fondamentale diversificare il database di formazione e i modelli di formazione per rilevare il contesto. Sebbene lo sviluppo di un algoritmo di moderazione dei contenuti affidabile possa sembrare impegnativo, inizia con il mettere le mani su set di dati di addestramento di alta qualità.

I fornitori di terze parti con la giusta competenza ed esperienza nella fornitura di set di dati di formazione adeguati sono i punti di partenza giusti.

Ogni azienda con una presenza sociale ha bisogno di un'avanguardia soluzione di moderazione dei contenuti che aiuta a costruire la fiducia dei clienti e un'esperienza cliente impeccabile. Per creare l'applicazione e addestrare il tuo modello di machine learning, devi accedere a un database di alta qualità privo di pregiudizi, allineato con le ultime tendenze linguistiche e di contenuto specifiche del mercato.

Con i nostri anni di esperienza nell'aiutare le aziende a lanciare modelli di intelligenza artificiale, Saip offre sistemi completi di raccolta dati che soddisfano diverse esigenze di moderazione dei contenuti.