Oggi, oltre 5.19 miliardi di persone esplorano Internet. È un pubblico vasto, non è vero?

L’enorme volume di contenuti generati su Internet è a dir poco sconcertante. Dagli aggiornamenti sui social media e post di blog ai commenti generati dagli utenti e ai caricamenti multimediali, il mondo online è un vasto e dinamico archivio di informazioni.

Tuttavia, non tutti i contenuti sono buoni. Alcuni potrebbero offendere vari gruppi a causa di età, razza, sesso, nazionalità o etnia. Tali contenuti richiedono un'attenta sorveglianza. Ciò garantisce pace e armonia a tutti.

Pertanto, nasce l’urgente necessità di moderazione dei contenuti. Anche se la revisione manuale è efficace, esistono alcune limitazioni che non possiamo ignorare. Ed è qui che la moderazione automatizzata dei contenuti diventa una soluzione efficace. Questo metodo efficiente garantisce esperienze online sicure e protegge gli utenti da potenziali danni.

In questo articolo parleremo dei vantaggi inestimabili e dei diversi tipi disponibili negli strumenti di moderazione automatizzata (preaddestrati con set di dati robusti).

Comprendere la moderazione automatizzata dei contenuti

La moderazione automatizzata dei contenuti utilizza la tecnologia per supervisionare e gestire i contenuti generati dagli utenti. Invece di essere umani a scansionare ogni post, gli algoritmi e l’apprendimento automatico fanno il lavoro pesante. Identificano rapidamente contenuti dannosi o inappropriati. Questi sistemi apprendono da vasti set di dati e prendono decisioni sulla base di criteri prestabiliti pre-addestrati con l'intervento umano.

I metodi automatizzati di moderazione dei contenuti possono essere altamente efficienti. Lavorano XNUMX ore su XNUMX ed esaminano istantaneamente grandi volumi di contenuti. Tuttavia, integrano anche i revisori umani. A volte un tocco umano è essenziale per il contesto. Questa combinazione garantisce spazi online più sicuri poiché gli utenti ottengono il meglio da entrambi i mondi.

Desideri una piattaforma priva di contenuti dannosi? La moderazione automatizzata dei contenuti è la strada da seguire. Lo renderemo più chiaro leggendo i tipi e i vantaggi riportati di seguito.

[Leggi anche: La guida necessaria alla moderazione dei contenuti]

Tipi di moderazione automatizzata

La moderazione automatizzata dei contenuti si è evoluta notevolmente nel corso degli anni. Ora incorpora una gamma di tecnologie e approcci, ciascuno progettato per soddisfare esigenze specifiche. Ecco uno sguardo più da vicino ai diversi tipi:

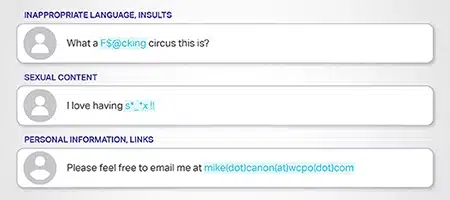

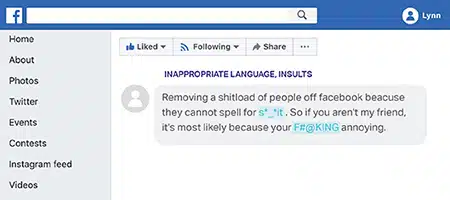

Moderazione basata su parole chiave

Questo metodo funziona su elenchi predefiniti di parole vietate o contrassegnate. Quando il contenuto contiene queste parole, il sistema ne nega la pubblicazione o lo invia per la revisione. Ad esempio, le piattaforme potrebbero bloccare linguaggio esplicito o termini legati all’incitamento all’odio.

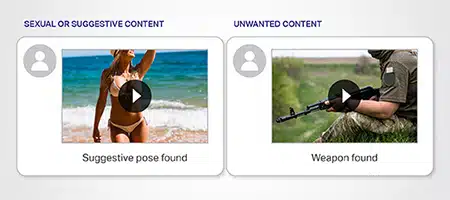

Moderazione del riconoscimento delle immagini

Sfruttando la potenza dell'apprendimento automatico, questo metodo identifica le immagini inappropriate o contrassegnate. Può rilevare immagini che promuovono la violenza, contenuti espliciti o materiali protetti da copyright. Algoritmi avanzati analizzano i modelli visivi per assicurarsi che nessuna immagine dannosa passi inosservata.

Moderazione dell'analisi video

Similmente al riconoscimento delle immagini, l'analisi video scompone i componenti video fotogramma per fotogramma. Verifica la presenza di immagini, segnali audio o contenuti contrassegnati inappropriati. Ha un valore inestimabile in piattaforme come YouTube in cui dominano i contenuti video.Moderazione dell'analisi del sentiment

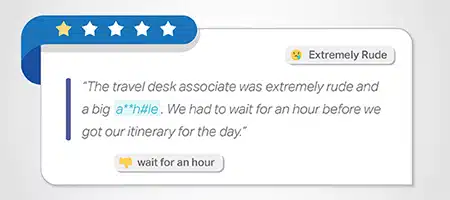

Comprendere il sentimento o l’emozione dietro il contenuto è vitale. Questo metodo valuta il tono dei contenuti e segnala quelli eccessivamente negativi, che promuovono l'odio o che incoraggiano sentimenti dannosi. È particolarmente utile nei forum o nelle piattaforme che promuovono interazioni positive con la comunità.

Moderazione contestuale

I contenuti spesso richiedono un contesto per una moderazione accurata. Questo metodo valuta il contenuto nel contesto circostante. Garantisce che i contenuti autentici, anche con parole contrassegnate, non vengano bloccati ingiustamente se il contesto generale è innocuo. Nell'esempio contiene la parola "uccidere", nel contesto è benigno e si riferisce all'attività innocua di giocare

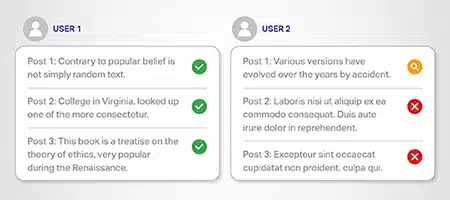

Moderazione basata sulla reputazione dell'utente

Gli utenti con precedenti di violazione delle linee guida potrebbero meritare un esame più attento. Questo sistema modera in base alla reputazione dell'utente. Coloro che hanno commesso infrazioni precedenti potrebbero vedere i loro contenuti revisionati in modo più rigoroso rispetto a quelli che hanno ricominciato da capo.

Moderazione del monitoraggio dei social media

Considerato il vasto contenuto generato sui social media, strumenti specializzati monitorano queste piattaforme. Rilevano potenziali problemi come disinformazione, notizie false o trolling in tempo reale. Aiuta a creare un ambiente di social media più pulito e sicuro.

Vantaggi della moderazione automatizzata

L’automazione porta con sé diversi vantaggi. Diamo uno sguardo più da vicino ai vantaggi offerti dalla moderazione automatizzata dei contenuti:

Filtraggio efficiente dei contenuti

Con l’aumento dei contenuti generati dagli utenti (UGC), le piattaforme necessitano di sistemi per vagliare grandi quantità. Offerte di moderazione automatizzata dei contenuti filtraggio efficiente dei contenuti. Garantisce che solo i materiali appropriati vedano la luce.

Sicurezza digitale migliorata

La sicurezza online è importante per aumentare la fiducia degli utenti nell'utilizzo di Internet. L'automazione aiuta a garantire la sicurezza digitale rilevando contenuti dannosi. Dall’incitamento all’odio alle molestie online, tiene a bada tali minacce.

Adesione alle Linee Guida della Comunità

Le linee guida della community mantengono l'integrità della piattaforma. L'automazione garantisce che queste regole non vengano violate e aiuta a creare spazi online armoniosi.

Lotta alle molestie online e all’incitamento all’odio

I sistemi automatizzati possono identificare ed eliminare rapidamente le molestie online e l’incitamento all’odio. Garantiscono che le piattaforme rimangano accoglienti e sicure segnalando i contenuti dannosi.

Affrontare la disinformazione e le fake news

Nell'età di disinformazione dilagante, l’automazione gioca un ruolo fondamentale. Rileva e sopprime la disinformazione/notizie false per sostenere la verità e l'accuratezza.

Affrontare la pesca a traina

Il trolling può rovinare i dialoghi online e far deragliare conversazioni significative. La moderazione automatizzata dei contenuti individua questi troll e aiuta a mantenere un ambiente positivo. Immagina un'aula. L'IT agisce come quella forza cauta che promuove interazioni costruttive e offre agli utenti un'esperienza migliore.

Analisi dettagliata

L'analisi del testo va oltre il semplice rilevamento delle parole chiave. Comprende il contesto e promuove contenuti autentici rimuovendo le narrazioni dannose. Oltre ai testi, gli strumenti di riconoscimento delle immagini rilevano immagini inappropriate. Garantiscono che le immagini siano allineate agli standard della piattaforma.

Moderazione video completa

I contenuti video dominano lo spazio digitale poiché le persone amano le immagini accattivanti. L'automazione interviene per garantire che questi video rispettino standard specifici. Passa al setaccio enormi volumi di contenuti, rileva elementi dannosi e li rimuove tempestivamente.

Conclusione

La moderazione automatizzata dei contenuti presenta sia vantaggi che sfide. Eccelle nella rimozione di contenuti non idonei dalle piattaforme digitali. Tuttavia, deve affrontare anche dei limiti e suscita dibattiti sulla censura e sul ruolo della tecnologia. In molti casi è necessaria anche la moderazione esperta da parte degli esseri umani in caso di ambiguità.

Le piattaforme dovrebbero essere chiare riguardo alle regole di moderazione. Hanno anche bisogno di sistemi che permettano agli utenti di contestare le decisioni di rimozione dei contenuti per correttezza e accuratezza. Con il giusto equilibrio, possiamo garantire l’equità per gli utenti online preservandone al tempo stesso la sicurezza e difendendo i loro diritti.

Questo metodo funziona su elenchi predefiniti di parole vietate o contrassegnate. Quando il contenuto contiene queste parole, il sistema ne nega la pubblicazione o lo invia per la revisione. Ad esempio, le piattaforme potrebbero bloccare linguaggio esplicito o termini legati all’incitamento all’odio.

Questo metodo funziona su elenchi predefiniti di parole vietate o contrassegnate. Quando il contenuto contiene queste parole, il sistema ne nega la pubblicazione o lo invia per la revisione. Ad esempio, le piattaforme potrebbero bloccare linguaggio esplicito o termini legati all’incitamento all’odio. Sfruttando la potenza dell'apprendimento automatico, questo metodo identifica le immagini inappropriate o contrassegnate. Può rilevare immagini che promuovono la violenza, contenuti espliciti o materiali protetti da copyright. Algoritmi avanzati analizzano i modelli visivi per assicurarsi che nessuna immagine dannosa passi inosservata.

Sfruttando la potenza dell'apprendimento automatico, questo metodo identifica le immagini inappropriate o contrassegnate. Può rilevare immagini che promuovono la violenza, contenuti espliciti o materiali protetti da copyright. Algoritmi avanzati analizzano i modelli visivi per assicurarsi che nessuna immagine dannosa passi inosservata.

Comprendere il sentimento o l’emozione dietro il contenuto è vitale. Questo metodo valuta il tono dei contenuti e segnala quelli eccessivamente negativi, che promuovono l'odio o che incoraggiano sentimenti dannosi. È particolarmente utile nei forum o nelle piattaforme che promuovono interazioni positive con la comunità.

Comprendere il sentimento o l’emozione dietro il contenuto è vitale. Questo metodo valuta il tono dei contenuti e segnala quelli eccessivamente negativi, che promuovono l'odio o che incoraggiano sentimenti dannosi. È particolarmente utile nei forum o nelle piattaforme che promuovono interazioni positive con la comunità. I contenuti spesso richiedono un contesto per una moderazione accurata. Questo metodo valuta il contenuto nel contesto circostante. Garantisce che i contenuti autentici, anche con parole contrassegnate, non vengano bloccati ingiustamente se il contesto generale è innocuo. Nell'esempio contiene la parola "uccidere", nel contesto è benigno e si riferisce all'attività innocua di giocare

I contenuti spesso richiedono un contesto per una moderazione accurata. Questo metodo valuta il contenuto nel contesto circostante. Garantisce che i contenuti autentici, anche con parole contrassegnate, non vengano bloccati ingiustamente se il contesto generale è innocuo. Nell'esempio contiene la parola "uccidere", nel contesto è benigno e si riferisce all'attività innocua di giocare Gli utenti con precedenti di violazione delle linee guida potrebbero meritare un esame più attento. Questo sistema modera in base alla reputazione dell'utente. Coloro che hanno commesso infrazioni precedenti potrebbero vedere i loro contenuti revisionati in modo più rigoroso rispetto a quelli che hanno ricominciato da capo.

Gli utenti con precedenti di violazione delle linee guida potrebbero meritare un esame più attento. Questo sistema modera in base alla reputazione dell'utente. Coloro che hanno commesso infrazioni precedenti potrebbero vedere i loro contenuti revisionati in modo più rigoroso rispetto a quelli che hanno ricominciato da capo. Considerato il vasto contenuto generato sui social media, strumenti specializzati monitorano queste piattaforme. Rilevano potenziali problemi come disinformazione, notizie false o trolling in tempo reale. Aiuta a creare un ambiente di social media più pulito e sicuro.

Considerato il vasto contenuto generato sui social media, strumenti specializzati monitorano queste piattaforme. Rilevano potenziali problemi come disinformazione, notizie false o trolling in tempo reale. Aiuta a creare un ambiente di social media più pulito e sicuro.