Nel fiorente campo dell’intelligenza artificiale (AI), l’attenzione su considerazioni etiche e sull’equità è più di un imperativo morale: è una necessità fondamentale per la longevità della tecnologia e l’accettazione sociale. L’intelligenza artificiale etica, o intelligenza artificiale giusta, significa garantire che i sistemi di intelligenza artificiale funzionino senza pregiudizi, discriminazioni o risultati ingiusti. Questo blog esplora l'importanza dell'intelligenza artificiale etica e approfondisce i vari tipi di pregiudizi da evitare.

Perché l’intelligenza artificiale etica è importante

I sistemi di intelligenza artificiale stanno diventando sempre più parte della nostra vita quotidiana, prendendo decisioni che influenzano tutto, dalle domande di lavoro alle sentenze giudiziarie. Quando questi sistemi sono distorti, possono perpetuare e amplificare le disuguaglianze sociali, causando danni a individui e gruppi. L’intelligenza artificiale etica mira a prevenire tali risultati promuovendo l’equità, la responsabilità, la trasparenza e il rispetto dei diritti umani.

Tipi di pregiudizi ed esempi

Pregiudizio sulla violenza

I sistemi di intelligenza artificiale devono essere addestrati a riconoscere e omettere contenuti violenti. Ad esempio, un modello linguistico addestrato su un testo violento potrebbe generare contenuti dannosi, promuovendo l’aggressività invece del dialogo costruttivo.

Argomenti controversi

Addestrare l’IA su argomenti controversi senza un’attenta moderazione può portare l’IA ad adottare posizioni polarizzate. Ad esempio, un’intelligenza artificiale addestrata sui dati sui diritti delle armi potrebbe generare argomenti controversi e unilaterali.

Discriminazione di genere

Un classico esempio di pregiudizio di genere è quando un modello linguistico associa gli infermieri alle donne e gli ingegneri agli uomini, rafforzando stereotipi obsoleti anziché riflettere la diversità di queste professioni.

Pregiudizi razziali ed etnici

Consideriamo un’intelligenza artificiale che genera immagini di amministratori delegati ma li descrive prevalentemente come appartenenti a un singolo gruppo razziale, ignorando così la realtà della diversità all’interno del mondo aziendale.

Distorsione socioeconomica

I sistemi di intelligenza artificiale possono favorire il linguaggio o i concetti associati a uno status socioeconomico più elevato, come supporre che i marchi di lusso siano lo standard di qualità, trascurando lo spettro più ampio di esperienze di consumo.

Pregiudizio sull’età

L’intelligenza artificiale potrebbe erroneamente presumere che i riferimenti alla tecnologia non siano rilevanti per gli anziani, escludendoli così dalle conversazioni sui progressi digitali.

Pregiudizio culturale

Un sistema di intelligenza artificiale potrebbe generare recensioni di ristoranti incentrate sulla cucina occidentale, ignorando la ricchezza di altre tradizioni culinarie e quindi emarginando le culture non occidentali.

Pregiudizio politico

Un’intelligenza artificiale programmata per curare articoli di notizie potrebbe selezionare in modo sproporzionato articoli dall’estremità sinistra o destra dello spettro politico, piuttosto che presentare una visione equilibrata.

Pregiudizi religiosi

Se un sistema di intelligenza artificiale fa riferimento in modo sproporzionato a una religione in una luce positiva mentre ignora o travisa le altre, mostra pregiudizi religiosi.

Pregiudizio regionale

Un modello linguistico potrebbe generare rapporti sul traffico rilevanti solo per le aree urbane, trascurando le regioni rurali o meno popolate.

Pregiudizio sulla disabilità

Prendiamo in considerazione un consulente sanitario basato sull’intelligenza artificiale che non riesce a fornire opzioni di esercizio accessibili per le persone con disabilità, offrendo così consigli incompleti ed esclusivi.

Bias linguistici

Un’intelligenza artificiale per la traduzione potrebbe fornire costantemente traduzioni di alta qualità per alcune lingue, ma scadenti per le lingue meno rappresentate nei suoi dati di addestramento.

Bias di conferma

Un’intelligenza artificiale potrebbe amplificare la convinzione di un utente in un falso rimedio facendo riferimento selettivamente a fonti che supportano quel rimedio e ignorando il consenso scientifico.

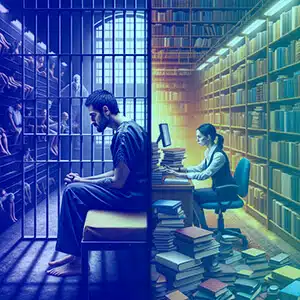

Bias contestuale

Un’intelligenza artificiale potrebbe interpretare le richieste di informazioni sulle “carceri” come un’indagine criminale, piuttosto che accademica o legale, a seconda del contesto su cui è stata addestrata.

Distorsione dell'origine dati

Se i dati di addestramento di un'intelligenza artificiale provengono da un forum che discute prevalentemente dei risultati di un determinato gruppo demografico, potrebbero trascurare i contributi di altri gruppi.

Come evitare questi pregiudizi

Evitare questi pregiudizi richiede un approccio articolato:

- Diversi set di dati: Incorporare un'ampia gamma di origini dati per bilanciare la rappresentanza tra diversi gruppi.

- Controllo regolare: Eseguire controlli continui per identificare e correggere i bias.

- Trasparenza: Chiarire in che modo i sistemi di intelligenza artificiale prendono decisioni e su quali dati vengono addestrati.

- Inclusività nei team AI: Team diversi possono identificare meglio potenziali pregiudizi che potrebbero essere trascurati.

- Formazione sull'etica: Educare gli sviluppatori di intelligenza artificiale sull'importanza delle considerazioni etiche.

- Feedback delle parti interessate: Coinvolgere gli utenti e le comunità interessate nel processo di sviluppo dell'IA.

Perché Shaip

Shaip, in qualità di leader nelle soluzioni di dati AI, offre servizi completi progettati per affrontare direttamente i pregiudizi dell'IA. Fornendo set di dati diversificati ed equilibrati per l'addestramento di modelli di intelligenza artificiale, Shaip garantisce che i tuoi sistemi di intelligenza artificiale siano esposti a un ampio spettro di esperienze umane e dati demografici, riducendo il rischio di pregiudizi su tutti i fronti, dal genere e la razza alla lingua e alla disabilità. I loro rigorosi processi di data curation e annotazione, abbinati a un quadro etico di intelligenza artificiale, possono aiutare le organizzazioni a identificare, mitigare e prevenire l’incorporazione di pregiudizi nei sistemi di intelligenza artificiale. L'esperienza di Shaip nello sviluppo di modelli su misura significa anche che può aiutare a creare un'intelligenza artificiale quanto più inclusiva, equa e imparziale possibile, allineandosi agli standard globali dell'intelligenza artificiale etica.

Conclusione

L’intelligenza artificiale etica è fondamentale per creare un futuro in cui la tecnologia sia al servizio dell’umanità senza pregiudizi. Comprendendo e mitigando i pregiudizi, gli sviluppatori e le parti interessate possono garantire che i sistemi di intelligenza artificiale siano giusti ed equi. La responsabilità spetta a tutti coloro che sono coinvolti nel ciclo di vita dell’IA di promuovere un ambiente in cui la tecnologia rispecchi i nostri più elevati standard etici, promuovendo una società giusta e inclusiva. Attraverso la vigilanza e la dedizione a questi principi, l’intelligenza artificiale può raggiungere il suo vero potenziale come forza del bene.