Large Language Models (LLM): guida completa nel 2023

Tutto ciò che devi sapere su LLM

Tabella dell'indice

- Introduzione

- Cosa sono i modelli linguistici di grandi dimensioni?

- Fattori essenziali

- Esempi popolari di LLM

- Elementi costitutivi di LLM

- Come vengono addestrati i modelli LLM?

- LLM si basa sull'apprendimento supervisionato o non supervisionato

- Treno LLM

- L'ascesa di LLM

- Casi d'uso popolari di LLM

- Sicurezza e conformità

- Messa a punto di un LLM

- FAQ

Scarica eBook

Introduzione

Ti sei mai grattato la testa, stupito di come Google o Alexa sembravano "prenderti"? O ti sei ritrovato a leggere un saggio generato dal computer che suona stranamente umano? Non sei solo. È ora di tirare indietro il sipario e rivelare il segreto: Large Language Models, o LLM.

Cosa sono questi, chiedi? Pensa agli LLM come maghi nascosti. Alimentano le nostre chat digitali, capiscono le nostre frasi confuse e persino scrivono come noi. Stanno trasformando le nostre vite, trasformando la fantascienza in realtà.

Questa guida è su tutto ciò che riguarda LLM. Esploreremo cosa possono fare, cosa non possono fare e dove vengono utilizzati. Esamineremo in che modo hanno un impatto su tutti noi con un linguaggio chiaro e semplice.

Quindi, iniziamo il nostro entusiasmante viaggio negli LLM.

A chi è rivolta questa guida?

Questa guida completa è per:

- Tutti voi imprenditori e imprenditori solisti che sgranocchiate regolarmente enormi quantità di dati

- AI e machine learning o professionisti che stanno iniziando con le tecniche di ottimizzazione dei processi

- Project manager che intendono implementare un time-to-market più rapido per i loro moduli di intelligenza artificiale o prodotti basati sull'intelligenza artificiale

- E gli appassionati di tecnologia a cui piace entrare nei dettagli dei livelli coinvolti nei processi di intelligenza artificiale.

Cosa sono i modelli linguistici di grandi dimensioni?

I Large Language Models (LLM) sono sistemi avanzati di intelligenza artificiale (AI) progettati per elaborare, comprendere e generare testo simile a quello umano. Si basano su tecniche di deep learning e sono addestrati su enormi set di dati, che di solito contengono miliardi di parole provenienti da diverse fonti come siti Web, libri e articoli. Questa vasta formazione consente agli LLM di cogliere le sfumature della lingua, della grammatica, del contesto e persino di alcuni aspetti della cultura generale.

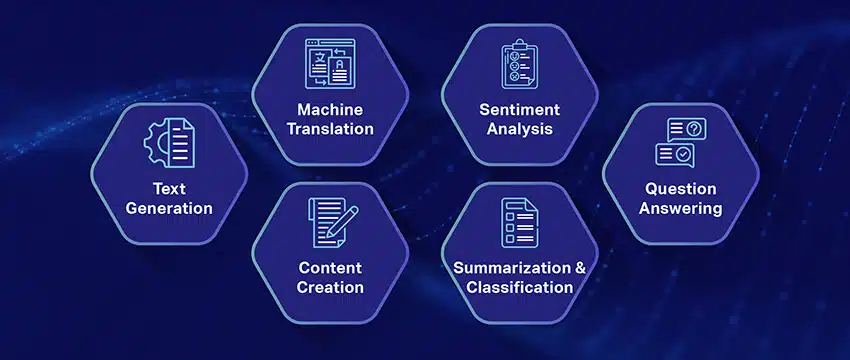

Alcuni LLM popolari, come GPT-3 di OpenAI, utilizzano un tipo di rete neurale chiamata trasformatore, che consente loro di gestire attività linguistiche complesse con notevole competenza. Questi modelli possono eseguire una vasta gamma di attività, come ad esempio:

- Rispondendo alle domande

- Testo riassuntivo

- Tradurre lingue

- Generazione di contenuti

- Anche impegnarsi in conversazioni interattive con gli utenti

Man mano che gli LLM continuano a evolversi, hanno un grande potenziale per migliorare e automatizzare varie applicazioni in tutti i settori, dal servizio clienti e dalla creazione di contenuti all'istruzione e alla ricerca. Tuttavia, sollevano anche preoccupazioni etiche e sociali, come il comportamento prevenuto o l'uso improprio, che devono essere affrontate man mano che la tecnologia avanza.

Fattori essenziali nella costruzione di un corpus di dati LLM

È necessario creare un corpus di dati completo per addestrare con successo i modelli linguistici. Questo processo implica la raccolta di grandi quantità di dati e la garanzia della loro elevata qualità e pertinenza. Diamo un'occhiata agli aspetti chiave che influenzano in modo significativo lo sviluppo di una libreria di dati efficace per la formazione del modello linguistico.

Dai priorità alla qualità dei dati oltre alla quantità

Un set di dati di grandi dimensioni è fondamentale per l’addestramento dei modelli linguistici. Tuttavia, la qualità dei dati è molto importante. I modelli addestrati su dati estesi ma scarsamente strutturati possono produrre risultati imprecisi.

Al contrario, set di dati più piccoli e meticolosamente curati spesso portano a prestazioni superiori. Questa realtà dimostra l’importanza di un approccio equilibrato alla raccolta dei dati. I dati rappresentativi, diversificati e pertinenti all'ambito previsto dal modello richiedono una selezione, pulizia e organizzazione diligente.

Seleziona origini dati appropriate

La scelta delle origini dati dovrebbe essere in linea con gli obiettivi applicativi specifici del modello.

- I modelli che generano dialogo trarrebbero vantaggio da fonti come conversazioni e interviste inestimabili.

- I modelli incentrati sulla generazione di codice trarranno vantaggio da repository di codice ben documentati.

- Le opere letterarie e le sceneggiature offrono una vasta gamma di materiale formativo per coloro che si dedicano alla scrittura creativa.

È necessario includere dati che coprano le lingue e gli argomenti previsti. Ti aiuta a personalizzare il modello affinché funzioni in modo efficace all'interno del dominio designato.

Utilizzare la generazione di dati sintetici

Migliorare il tuo set di dati con dati sintetici può colmare le lacune ed estenderne la portata. Puoi utilizzare l'aumento dei dati, i modelli di generazione del testo e la generazione basata su regole per creare dati artificiali che riflettano modelli del mondo reale. Questa strategia amplia la diversità del set di formazione per migliorare la resilienza del modello e contribuire a ridurre i pregiudizi.

Assicurati di verificare la qualità dei dati sintetici in modo che contribuiscano positivamente alla capacità del modello di comprendere e generare linguaggio all'interno del suo dominio di destinazione.

Implementare la raccolta automatizzata dei dati

L'automazione del processo di raccolta dati facilita l'integrazione coerente di dati nuovi e pertinenti. Questo approccio semplifica l'acquisizione dei dati, aumenta la scalabilità e promuove la riproducibilità.

Puoi raccogliere in modo efficiente diversi set di dati utilizzando strumenti di web scraping, API e framework di inserimento dati. Puoi ottimizzare questi strumenti per concentrarti su dati pertinenti e di alta qualità. Ottimizzano il materiale di formazione per il modello. È necessario monitorare continuamente questi sistemi automatizzati per mantenerne l'accuratezza e l'integrità etica.

Esempi popolari di modelli linguistici di grandi dimensioni

Ecco alcuni esempi importanti di LLM ampiamente utilizzati in diversi settori verticali:

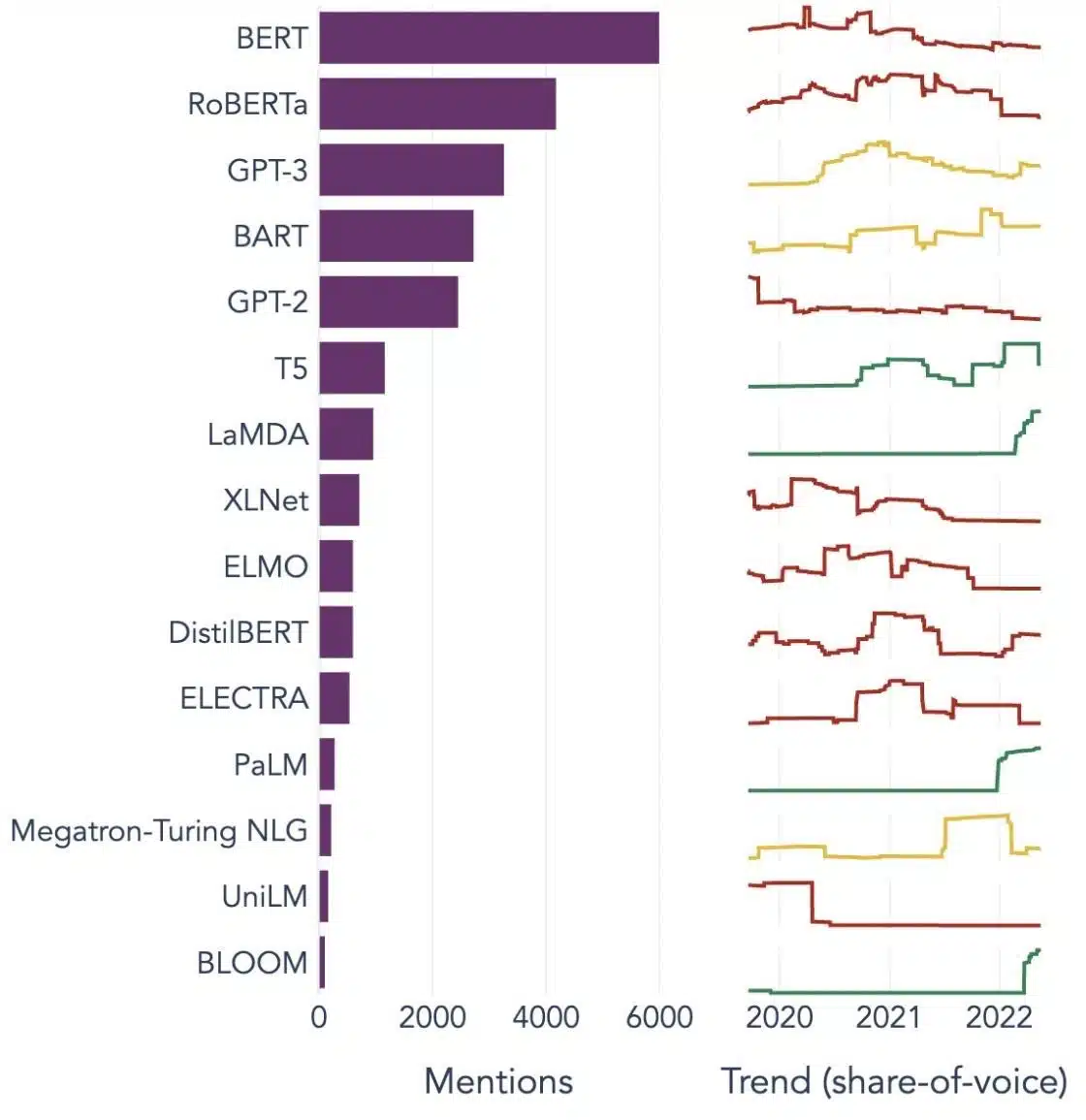

Image Source: Verso la scienza dei dati

Comprensione degli elementi costitutivi dei modelli linguistici di grandi dimensioni (LLM)

Per comprendere appieno le capacità e il funzionamento degli LLM, è importante familiarizzare con alcuni concetti chiave. Questi includono:

Incorporamento di parole

Questo si riferisce alla pratica di tradurre le parole in un formato numerico che i modelli AI possono interpretare. In sostanza, il word embedding è il linguaggio dell'IA. Ogni parola è rappresentata come un vettore ad alta dimensione che ne incapsula il significato semantico in base al suo contesto nei dati di addestramento. Questi vettori consentono all'IA di comprendere le relazioni e le somiglianze tra le parole, migliorando la comprensione e le prestazioni del modello.

Meccanismi di attenzione

Questi componenti sofisticati aiutano il modello AI a dare la priorità a determinati elementi all'interno del testo di input rispetto ad altri durante la generazione di un output. Ad esempio, in una frase piena di vari sentimenti, un meccanismo di attenzione potrebbe dare un peso maggiore alle parole portatrici di sentimenti. Questa strategia consente all'IA di generare risposte contestualmente più accurate e sfumate.

Trasformatori

I trasformatori rappresentano un tipo avanzato di architettura di rete neurale ampiamente utilizzata nella ricerca LLM. Ciò che distingue i trasformatori è il loro meccanismo di auto-attenzione. Questo meccanismo consente al modello di pesare e considerare tutte le parti dei dati di input contemporaneamente, anziché in ordine sequenziale. Il risultato è un miglioramento nella gestione delle dipendenze a lungo raggio nel testo, una sfida comune nelle attività di elaborazione del linguaggio naturale.

Ritocchi

Anche gli LLM più avanzati richiedono una certa personalizzazione per eccellere in compiti o domini specifici. È qui che entra in gioco la messa a punto. Dopo che un modello è stato inizialmente addestrato su un set di dati di grandi dimensioni, può essere ulteriormente perfezionato o "messo a punto" su un set di dati più piccolo e più specifico. Questo processo consente al modello di adattare le sue capacità di comprensione del linguaggio generalizzate a un compito o contesto più specializzato.

Ingegneria rapida

I prompt di input servono come punto di partenza per gli LLM per generare output. La creazione efficace di questi prompt, una pratica nota come ingegneria dei prompt, può influenzare notevolmente la qualità delle risposte del modello. È una miscela di arte e scienza che richiede una profonda comprensione di come il modello interpreta i suggerimenti e genera risposte.

Pregiudizio

Man mano che gli LLM apprendono dai dati su cui sono formati, qualsiasi pregiudizio presente in questi dati può infiltrarsi nel comportamento del modello. Ciò potrebbe manifestarsi come tendenze discriminatorie o sleali negli output del modello. Affrontare e mitigare questi pregiudizi è una sfida significativa nel campo dell'IA e un aspetto cruciale dello sviluppo di LLM eticamente validi.

interpretabilità

Data la complessità degli LLM, capire perché prendono determinate decisioni o generano risultati specifici può essere difficile. Questa caratteristica, nota come interpretabilità, è un'area chiave della ricerca in corso. Migliorare l'interpretabilità non solo aiuta nella risoluzione dei problemi e nel perfezionamento del modello, ma rafforza anche la fiducia e la trasparenza nei sistemi di intelligenza artificiale.

Come vengono addestrati i modelli LLM?

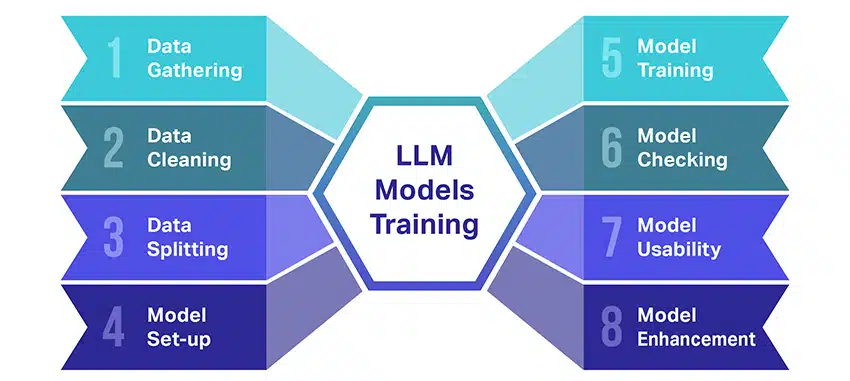

La formazione di modelli linguistici di grandi dimensioni (LLM) è piuttosto un'impresa che comporta diversi passaggi cruciali. Ecco un resoconto semplificato e dettagliato del processo:

- Raccolta di dati testuali: La formazione di un LLM inizia con la raccolta di una grande quantità di dati di testo. Questi dati possono provenire da libri, siti Web, articoli o piattaforme di social media. L'obiettivo è catturare la ricca diversità del linguaggio umano.

- Pulizia dei dati: I dati di testo non elaborati vengono quindi riordinati in un processo chiamato preelaborazione. Ciò include attività come la rimozione di caratteri indesiderati, la suddivisione del testo in parti più piccole chiamate token e l'inserimento di tutto in un formato con cui il modello può funzionare.

- Divisione dei dati: Successivamente, i dati puliti vengono suddivisi in due set. Un set, i dati di addestramento, verrà utilizzato per addestrare il modello. L'altro set, i dati di convalida, verrà utilizzato successivamente per testare le prestazioni del modello.

- Impostazione del modello: Viene quindi definita la struttura del LLM, nota come architettura. Ciò comporta la selezione del tipo di rete neurale e la decisione su vari parametri, come il numero di livelli e le unità nascoste all'interno della rete.

- Formazione del modello: Ora inizia l'allenamento vero e proprio. Il modello LLM apprende osservando i dati di addestramento, effettuando previsioni basate su ciò che ha appreso finora e quindi regolando i suoi parametri interni per ridurre la differenza tra le sue previsioni e i dati effettivi.

- Controllo del modello: L'apprendimento del modello LLM viene verificato utilizzando i dati di convalida. Questo aiuta a vedere le prestazioni del modello e a modificare le impostazioni del modello per prestazioni migliori.

- Utilizzo del modello: Dopo la formazione e la valutazione, il modello LLM è pronto per l'uso. Ora può essere integrato in applicazioni o sistemi in cui genererà testo in base ai nuovi input forniti.

- Migliorare il modello: Infine, c'è sempre spazio per migliorare. Il modello LLM può essere ulteriormente perfezionato nel tempo, utilizzando dati aggiornati o regolando le impostazioni in base al feedback e all'utilizzo nel mondo reale.

Ricorda, questo processo richiede notevoli risorse computazionali, come potenti unità di elaborazione e spazio di archiviazione di grandi dimensioni, nonché conoscenze specializzate nell'apprendimento automatico. Ecco perché di solito viene svolto da organizzazioni o società di ricerca dedicate con accesso alle infrastrutture e alle competenze necessarie.

Il LLM si basa sull'apprendimento supervisionato o non supervisionato?

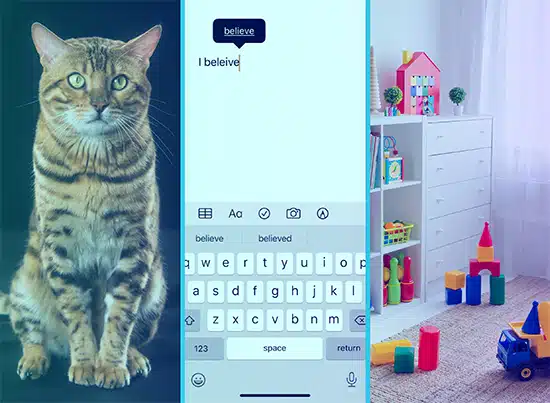

I modelli linguistici di grandi dimensioni vengono generalmente addestrati utilizzando un metodo chiamato apprendimento supervisionato. In termini semplici, ciò significa che imparano da esempi che mostrano loro le risposte corrette.

Quindi, se dai da mangiare a un LLM una frase, cerca di prevedere la parola o la frase successiva in base a ciò che ha appreso dagli esempi. In questo modo, impara a generare un testo che abbia senso e si adatti al contesto.

Detto questo, a volte gli LLM usano anche un po' di apprendimento senza supervisione. È come lasciare che il bambino esplori una stanza piena di giocattoli diversi e impari a conoscerli da solo. Il modello esamina i dati non etichettati, i modelli di apprendimento e le strutture senza ricevere le risposte "giuste".

L'apprendimento supervisionato utilizza dati che sono stati etichettati con input e output, a differenza dell'apprendimento non supervisionato, che non utilizza dati di output etichettati.

In poche parole, gli LLM sono formati principalmente utilizzando l'apprendimento supervisionato, ma possono anche utilizzare l'apprendimento non supervisionato per migliorare le loro capacità, ad esempio per l'analisi esplorativa e la riduzione della dimensionalità.

Qual è il volume di dati (in GB) necessario per addestrare un modello linguistico di grandi dimensioni?

Il mondo delle possibilità per il riconoscimento dei dati vocali e le applicazioni vocali è immenso e vengono utilizzate in diversi settori per una miriade di applicazioni.

L'addestramento di un modello linguistico di grandi dimensioni non è un processo valido per tutti, soprattutto quando si tratta dei dati necessari. Dipende da un sacco di cose:

- Il disegno del modello.

- Che lavoro deve fare?

- Il tipo di dati che stai utilizzando.

- Quanto bene vuoi che funzioni?

Detto questo, la formazione degli LLM di solito richiede un'enorme quantità di dati di testo. Ma di quanto massiccio stiamo parlando? Bene, pensa ben oltre i gigabyte (GB). Di solito guardiamo terabyte (TB) o addirittura petabyte (PB) di dati.

Considera GPT-3, uno dei più grandi LLM in circolazione. È addestrato 570 GB di dati di testo. Gli LLM più piccoli potrebbero aver bisogno di meno, forse 10-20 GB o anche 1 GB di gigabyte, ma è comunque molto.

Ma non si tratta solo della dimensione dei dati. Anche la qualità conta. I dati devono essere puliti e vari per aiutare il modello ad apprendere in modo efficace. E non puoi dimenticare altri pezzi chiave del puzzle, come la potenza di calcolo di cui hai bisogno, gli algoritmi che usi per l'addestramento e la configurazione hardware che hai. Tutti questi fattori giocano un ruolo importante nella formazione di un LLM.

L'ascesa dei modelli linguistici di grandi dimensioni: perché contano

Gli LLM non sono più solo un concetto o un esperimento. Stanno giocando sempre più un ruolo fondamentale nel nostro panorama digitale. Ma perché sta succedendo questo? Cosa rende questi LLM così importanti? Approfondiamo alcuni fattori chiave.

Padronanza nell'imitazione del testo umano

Gli LLM hanno trasformato il modo in cui gestiamo le attività basate sulla lingua. Costruiti utilizzando robusti algoritmi di apprendimento automatico, questi modelli sono dotati della capacità di comprendere le sfumature del linguaggio umano, inclusi il contesto, le emozioni e persino il sarcasmo, in una certa misura. Questa capacità di imitare il linguaggio umano non è una mera novità, ha implicazioni significative.

Le capacità avanzate di generazione di testo degli LLM possono migliorare tutto, dalla creazione di contenuti alle interazioni con il servizio clienti.

Immagina di poter porre una domanda complessa a un assistente digitale e ottenere una risposta che non solo abbia senso, ma sia anche coerente, pertinente e fornita in tono colloquiale. Questo è ciò che gli LLM stanno abilitando. Stanno alimentando un'interazione uomo-macchina più intuitiva e coinvolgente, arricchendo le esperienze degli utenti e democratizzando l'accesso alle informazioni.

Potenza di calcolo accessibile

L'ascesa di LLM non sarebbe stata possibile senza sviluppi paralleli nel campo dell'informatica. Più specificamente, la democratizzazione delle risorse computazionali ha svolto un ruolo significativo nell'evoluzione e nell'adozione degli LLM.

Le piattaforme basate su cloud offrono un accesso senza precedenti a risorse di elaborazione ad alte prestazioni. In questo modo, anche organizzazioni su piccola scala e ricercatori indipendenti possono addestrare sofisticati modelli di machine learning.

Inoltre, i miglioramenti nelle unità di elaborazione (come GPU e TPU), combinati con l'aumento del calcolo distribuito, hanno reso possibile l'addestramento di modelli con miliardi di parametri. Questa maggiore accessibilità della potenza di calcolo sta consentendo la crescita e il successo degli LLM, portando a più innovazione e applicazioni nel campo.

Spostare le preferenze dei consumatori

I consumatori oggi non vogliono solo risposte; vogliono interazioni coinvolgenti e riconoscibili. Man mano che sempre più persone crescono utilizzando la tecnologia digitale, è evidente che la necessità di una tecnologia che sembri più naturale e umana è in aumento. Gli LLM offrono un'opportunità senza pari per soddisfare queste aspettative. Generando testo simile a quello umano, questi modelli possono creare esperienze digitali coinvolgenti e dinamiche, che possono aumentare la soddisfazione e la lealtà degli utenti. Che si tratti di chatbot AI che forniscono assistenza clienti o assistenti vocali che forniscono aggiornamenti sulle notizie, gli LLM stanno inaugurando un'era di AI che ci comprende meglio.

La miniera d'oro dei dati non strutturati

I dati non strutturati, come le e-mail, i post sui social media e le recensioni dei clienti, sono un tesoro di approfondimenti. Si stima che sia finita 80% dei dati aziendali non è strutturato e cresce a un ritmo di 55% per anno. Questi dati sono una miniera d'oro per le aziende se sfruttati correttamente.

Gli LLM entrano in gioco qui, con la loro capacità di elaborare e dare un senso a tali dati su larga scala. Possono gestire attività come l'analisi del sentiment, la classificazione del testo, l'estrazione di informazioni e altro ancora, fornendo così preziose informazioni.

Che si tratti di identificare le tendenze dai post sui social media o di valutare il sentimento dei clienti dalle recensioni, gli LLM aiutano le aziende a navigare nella grande quantità di dati non strutturati e a prendere decisioni basate sui dati.

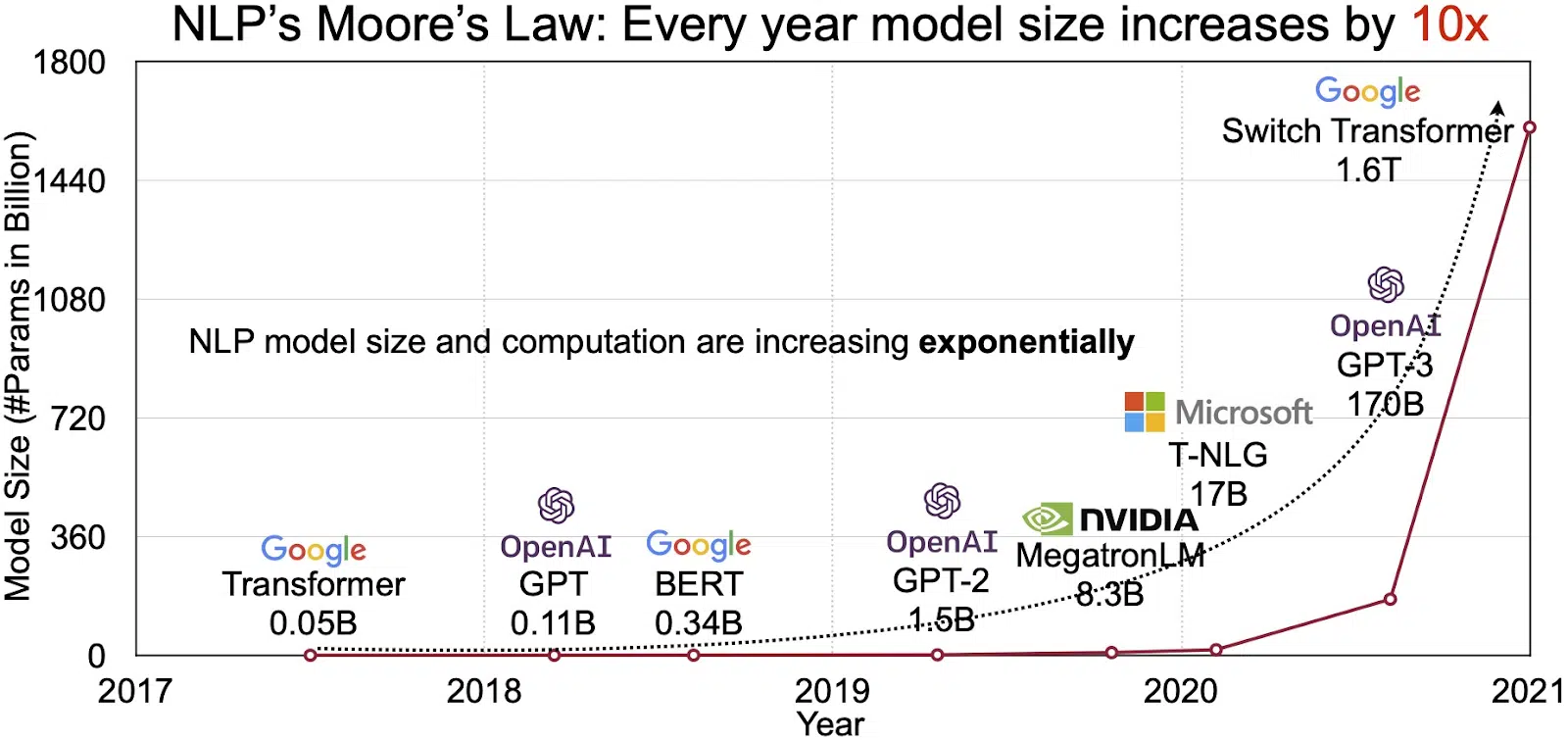

Il mercato della PNL in espansione

Il potenziale degli LLM si riflette nel mercato in rapida crescita dell'elaborazione del linguaggio naturale (NLP). Gli analisti prevedono che il mercato della PNL si espanderà $ 11 miliardi nel 2020 a oltre $ 35 miliardi entro il 2026. Ma non è solo la dimensione del mercato che si sta espandendo. Anche i modelli stessi stanno crescendo, sia nelle dimensioni fisiche che nel numero di parametri che gestiscono. L'evoluzione degli LLM nel corso degli anni, come si vede nella figura sottostante (fonte immagine: link), sottolinea la loro crescente complessità e capacità.

Casi d'uso popolari di modelli linguistici di grandi dimensioni

Ecco alcuni dei casi d'uso principali e più diffusi di LLM:

- Generazione di testo in linguaggio naturale: I Large Language Models (LLM) combinano la potenza dell'intelligenza artificiale e della linguistica computazionale per produrre autonomamente testi in linguaggio naturale. Possono soddisfare le diverse esigenze degli utenti come scrivere articoli, creare canzoni o impegnarsi in conversazioni con gli utenti.

- Traduzione tramite macchine: Gli LLM possono essere efficacemente impiegati per tradurre il testo tra qualsiasi coppia di lingue. Questi modelli sfruttano algoritmi di deep learning come le reti neurali ricorrenti per comprendere la struttura linguistica delle lingue di partenza e di arrivo, facilitando così la traduzione del testo di partenza nella lingua desiderata.

- Creazione di contenuti originali: Gli LLM hanno aperto strade alle macchine per generare contenuti coerenti e logici. Questo contenuto può essere utilizzato per creare post di blog, articoli e altri tipi di contenuto. I modelli attingono alla loro profonda esperienza di apprendimento profondo per formattare e strutturare il contenuto in un modo nuovo e intuitivo.

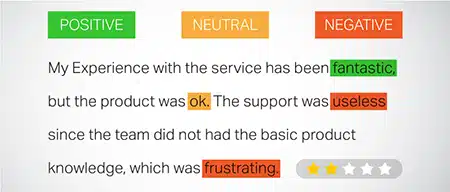

- Analisi dei sentimenti: Un'interessante applicazione dei Large Language Models è l'analisi del sentiment. In questo, il modello è addestrato a riconoscere e classificare stati emotivi e sentimenti presenti nel testo annotato. Il software può identificare emozioni come positività, negatività, neutralità e altri sentimenti complessi. Ciò può fornire preziose informazioni sul feedback dei clienti e opinioni su vari prodotti e servizi.

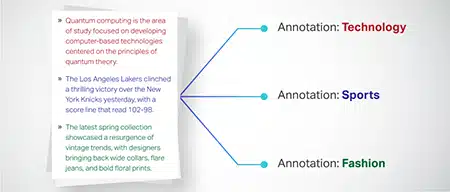

- Comprendere, riassumere e classificare il testo: Gli LLM stabiliscono una struttura praticabile per il software AI per interpretare il testo e il suo contesto. Istruendo il modello a comprendere e analizzare grandi quantità di dati, gli LLM consentono ai modelli di intelligenza artificiale di comprendere, riassumere e persino classificare il testo in diverse forme e modelli.

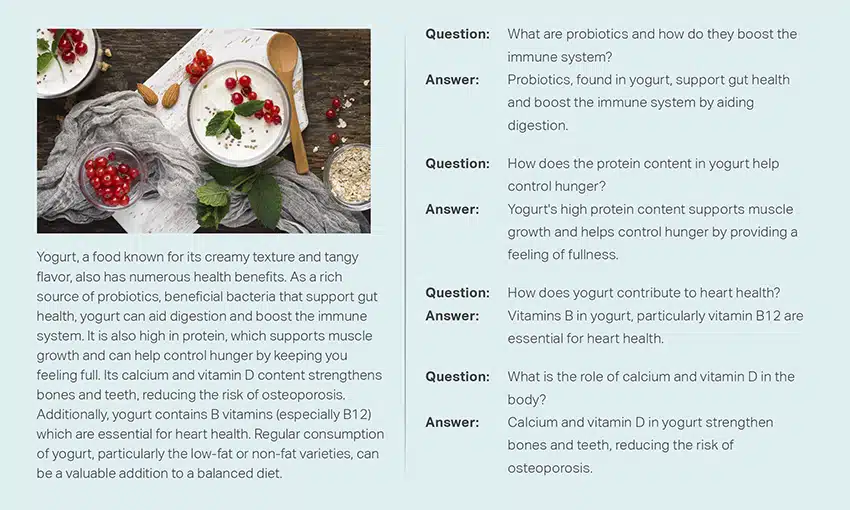

- Rispondendo alle domande: I Large Language Models dotano i sistemi di risposta alle domande (QA) della capacità di percepire e rispondere con precisione alla domanda in linguaggio naturale di un utente. Esempi popolari di questo caso d'uso includono ChatGPT e BERT, che esaminano il contesto di una query e setacciano una vasta raccolta di testi per fornire risposte pertinenti alle domande degli utenti.

Integrazione di sicurezza e conformità nelle strategie di dati LLM

L'integrazione di solide misure di sicurezza e conformità all'interno dei framework di raccolta ed elaborazione dei dati LLM può aiutarti a garantire l'uso trasparente, sicuro ed etico dei dati. Questo approccio comprende diverse azioni chiave:

- Implementare la crittografia robusta: Proteggi i dati inattivi e in transito utilizzando metodi di crittografia avanzati. Questo passaggio protegge le informazioni da accessi non autorizzati e violazioni.

- Stabilire controlli di accesso e autenticazione: impostare sistemi per verificare l'identità degli utenti e limitare l'accesso ai dati. Garantirà che solo il personale autorizzato possa interagire con le informazioni sensibili.

- Integrare sistemi di registrazione e monitoraggio: implementare sistemi per monitorare l'utilizzo dei dati e identificare potenziali minacce alla sicurezza. Questo monitoraggio proattivo aiuta a mantenere l’integrità e la sicurezza dell’ecosistema dei dati.

- Aderire agli standard di conformità: seguire le normative pertinenti come GDPR, HIPAA e PCI DSS, che regolano la sicurezza e la privacy dei dati. Audit e controlli regolari verificano la conformità, garantendo che le pratiche soddisfino gli standard legali ed etici specifici del settore.

- Stabilire linee guida etiche per l'utilizzo dei dati: Sviluppare e applicare politiche che stabiliscano l’uso equo, trasparente e responsabile dei dati. Queste linee guida aiutano a mantenere la fiducia delle parti interessate e supportano un ambiente di formazione sicuro per i LLM.

Queste azioni rafforzano collettivamente le pratiche di gestione dei dati per la formazione LLM. Costruisce una base di fiducia e sicurezza a vantaggio di tutte le parti interessate coinvolte.

Messa a punto di un modello di linguaggio di grandi dimensioni

La messa a punto di un modello di linguaggio di grandi dimensioni comporta un meticoloso processo di annotazione. Shaip, con la sua esperienza in questo campo, può aiutare in modo significativo questo sforzo. Ecco alcuni metodi di annotazione utilizzati per addestrare modelli come ChatGPT:

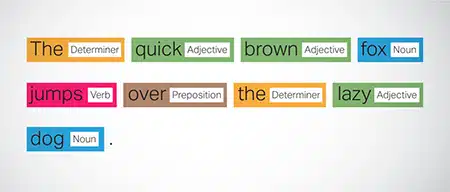

Tagging parte del discorso (POS).

Le parole nelle frasi sono etichettate con la loro funzione grammaticale, come verbi, sostantivi, aggettivi, ecc. Questo processo aiuta il modello a comprendere la grammatica e i collegamenti tra le parole.

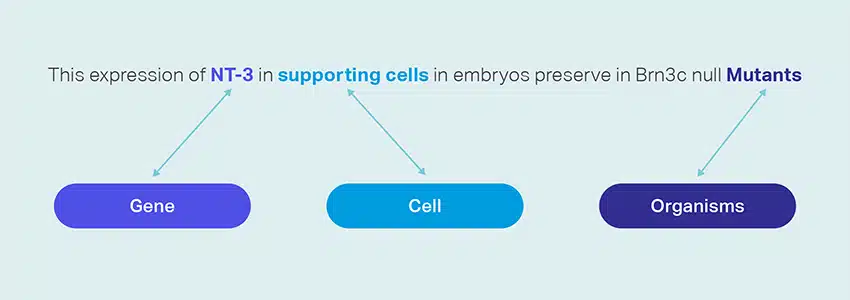

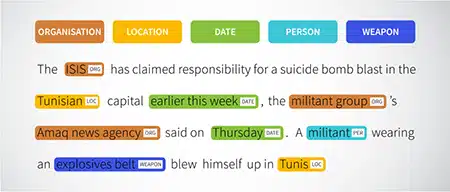

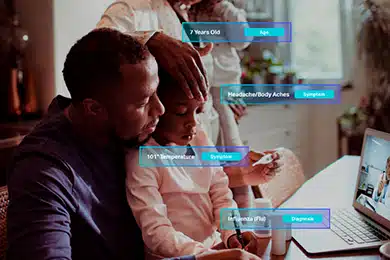

Riconoscimento entità designata (NER)

Le entità denominate come organizzazioni, luoghi e persone all'interno di una frase sono contrassegnate. Questo esercizio aiuta il modello a interpretare i significati semantici di parole e frasi e fornisce risposte più precise.

Analisi del sentimento

Ai dati di testo vengono assegnate etichette di sentimento come positivo, neutro o negativo, aiutando il modello a cogliere il sottofondo emotivo delle frasi. È particolarmente utile per rispondere a domande che coinvolgono emozioni e opinioni.

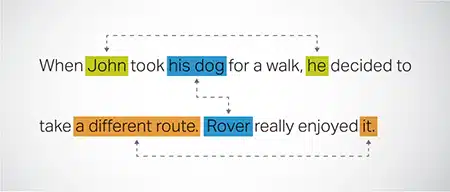

Risoluzione sulla coreferenza

Identificare e risolvere casi in cui la stessa entità è citata in parti diverse di un testo. Questo passaggio aiuta il modello a comprendere il contesto della frase, portando così a risposte coerenti.

Classificazione del testo

I dati di testo sono classificati in gruppi predefiniti come recensioni di prodotti o articoli di notizie. Questo aiuta il modello a discernere il genere o l'argomento del testo, generando risposte più pertinenti.

Saip può raccogliere dati di addestramento tramite scansione web da vari settori come banche, assicurazioni, vendita al dettaglio e telecomunicazioni. Possiamo fornire annotazioni di testo (NER, analisi del sentimento, ecc.), facilitare LLM multilingue (traduzione) e assistere nella creazione di tassonomie, estrazione/prompt engineering.

Shaip dispone di un vasto archivio di set di dati standard. Il nostro catalogo di dati medici vanta un'ampia raccolta di dati anonimizzati, sicuri e di qualità adatti a iniziative di intelligenza artificiale, modelli di apprendimento automatico ed elaborazione del linguaggio naturale.

Allo stesso modo, il nostro catalogo di dati vocali è un tesoro di dati di alta qualità perfetti per i prodotti di riconoscimento vocale, che consentono un addestramento efficiente dei modelli AI/ML. Abbiamo anche un impressionante catalogo di dati sulla visione artificiale con una vasta gamma di dati di immagini e video per varie applicazioni.

Offriamo persino set di dati aperti in una forma modificabile e conveniente, gratuitamente, da utilizzare nei tuoi progetti di AI e ML. Questa vasta libreria di dati AI ti consente di sviluppare i tuoi modelli AI e ML in modo più efficiente e accurato.

Processo di raccolta dati e annotazione di Shaip

Quando si tratta di raccolta dati e annotazione, Saip segue un flusso di lavoro semplificato. Ecco come si presenta il processo di raccolta dei dati:

Identificazione dei siti Web di origine

Inizialmente, i siti Web vengono individuati utilizzando fonti selezionate e parole chiave pertinenti ai dati richiesti.

Scraping Web

Una volta identificati i siti Web pertinenti, Shaip utilizza il proprio strumento proprietario per raccogliere dati da questi siti.

Preelaborazione del testo

I dati raccolti vengono sottoposti a un'elaborazione iniziale, che include la suddivisione e l'analisi delle frasi, rendendoli adatti a ulteriori passaggi.

Annotazione

I dati pre-elaborati vengono annotati per l'estrazione di entità denominate. Questo processo comporta l'identificazione e l'etichettatura di elementi importanti all'interno del testo, come nomi di persone, organizzazioni, luoghi, ecc.

Estrazione di relazioni

Nella fase finale, i tipi di relazioni tra le entità identificate vengono determinati e annotati di conseguenza. Questo aiuta a comprendere le connessioni semantiche tra i diversi componenti del testo.

L'offerta di Shaip

Saip offre una vasta gamma di servizi per aiutare le organizzazioni a gestire, analizzare e sfruttare al meglio i propri dati.

Scraping Web dei dati

Un servizio chiave offerto da Shaip è lo scraping dei dati. Ciò comporta l'estrazione di dati da URL specifici del dominio. Utilizzando strumenti e tecniche automatizzati, Shaip può raccogliere in modo rapido ed efficiente grandi volumi di dati da vari siti Web, manuali di prodotti, documentazione tecnica, forum online, recensioni online, dati del servizio clienti, documenti normativi del settore, ecc. Questo processo può essere prezioso per le aziende quando raccogliere dati pertinenti e specifici da una moltitudine di fonti.

Traduzione automatica

Sviluppa modelli utilizzando ampi set di dati multilingue abbinati a trascrizioni corrispondenti per tradurre il testo in varie lingue. Questo processo aiuta a smantellare gli ostacoli linguistici e promuove l'accessibilità delle informazioni.

Estrazione e creazione della tassonomia

Shaip può aiutare con l'estrazione e la creazione della tassonomia. Ciò comporta la classificazione e la categorizzazione dei dati in un formato strutturato che riflette le relazioni tra diversi punti dati. Ciò può essere particolarmente utile per le aziende nell'organizzazione dei propri dati, rendendoli più accessibili e più facili da analizzare. Ad esempio, in un'attività di e-commerce, i dati sui prodotti potrebbero essere classificati in base al tipo di prodotto, alla marca, al prezzo, ecc., rendendo più facile per i clienti navigare nel catalogo dei prodotti.

Raccolta Dati

I nostri servizi di raccolta dati forniscono dati critici del mondo reale o sintetici necessari per addestrare algoritmi di intelligenza artificiale generativa e migliorare l'accuratezza e l'efficacia dei tuoi modelli. I dati provengono da fonti imparziali, etiche e responsabili, tenendo presente la privacy e la sicurezza dei dati.

Domanda e risposta

La risposta alle domande (QA) è un sottocampo dell'elaborazione del linguaggio naturale incentrato sulla risposta automatica alle domande nel linguaggio umano. I sistemi di QA sono addestrati su testo e codice estesi, consentendo loro di gestire vari tipi di domande, comprese quelle fattuali, di definizione e basate sull'opinione. La conoscenza del dominio è fondamentale per lo sviluppo di modelli di QA su misura per campi specifici come l'assistenza clienti, l'assistenza sanitaria o la catena di fornitura. Tuttavia, gli approcci generativi di QA consentono ai modelli di generare testo senza la conoscenza del dominio, basandosi esclusivamente sul contesto.

Il nostro team di specialisti può studiare meticolosamente documenti o manuali completi per generare coppie Domanda-Risposta, facilitando la creazione di AI generativa per le aziende. Questo approccio può affrontare efficacemente le richieste degli utenti estraendo informazioni pertinenti da un vasto corpus. I nostri esperti certificati garantiscono la produzione di coppie di domande e risposte di alta qualità che abbracciano diversi argomenti e domini.

Riepilogo del testo

I nostri specialisti sono in grado di distillare conversazioni complete o lunghi dialoghi, fornendo riassunti succinti e approfonditi da dati di testo estesi.

Generazione di testo

Addestra i modelli utilizzando un ampio set di dati di testo in stili diversi, come articoli di notizie, narrativa e poesia. Questi modelli possono quindi generare vari tipi di contenuto, tra cui notizie, voci di blog o post sui social media, offrendo una soluzione economica e che fa risparmiare tempo per la creazione di contenuti.

Riconoscimento vocale

Sviluppare modelli in grado di comprendere il linguaggio parlato per varie applicazioni. Ciò include assistenti ad attivazione vocale, software di dettatura e strumenti di traduzione in tempo reale. Il processo prevede l'utilizzo di un set di dati completo composto da registrazioni audio della lingua parlata, abbinate alle trascrizioni corrispondenti.

Consigli sul prodotto

Sviluppa modelli utilizzando set di dati estesi di cronologie di acquisto dei clienti, incluse etichette che indicano i prodotti che i clienti sono inclini ad acquistare. L'obiettivo è quello di fornire suggerimenti precisi ai clienti, aumentando così le vendite e aumentando la soddisfazione del cliente.

Sottotitoli delle immagini

Rivoluziona il tuo processo di interpretazione delle immagini con il nostro servizio di sottotitoli delle immagini all'avanguardia basato sull'intelligenza artificiale. Infondiamo vitalità nelle immagini producendo descrizioni accurate e contestualmente significative. Questo apre la strada a possibilità innovative di coinvolgimento e interazione con i tuoi contenuti visivi per il tuo pubblico.

Formazione sui servizi di sintesi vocale

Forniamo un ampio set di dati composto da registrazioni audio del parlato umano, ideale per l'addestramento di modelli di intelligenza artificiale. Questi modelli sono in grado di generare voci naturali e coinvolgenti per le tue applicazioni, offrendo così un'esperienza sonora distintiva e coinvolgente per i tuoi utenti.

Il nostro variegato catalogo di dati è progettato per soddisfare numerosi casi d'uso di IA generativa

Catalogo e licenza di dati medici pronti all'uso:

- 5 milioni di record e file audio medici in 31 specialità

- 2 milioni di immagini mediche in radiologia e altre specialità (MRI, TC, USG, XR)

- Oltre 30 documenti di testo clinico con entità a valore aggiunto e annotazione di relazioni

Catalogo e licenza dei dati vocali pronti all'uso:

- Oltre 40 ore di dati vocali (50+ lingue/100+ dialetti)

- Oltre 55 argomenti trattati

- Frequenza di campionamento – 8/16/44/48 kHz

- Tipo di audio: parole spontanee, sceneggiate, monologiche, di risveglio

- Set di dati audio completamente trascritti in più lingue per conversazioni uomo-uomo, uomo-bot, conversazione call center uomo-agente, monologhi, discorsi, podcast, ecc.

Catalogo dati immagine e video e licenze:

- Raccolta di immagini di alimenti/documenti

- Raccolta di video sulla sicurezza domestica

- Raccolta di immagini/video facciali

- Fatture, PO, Ricevute Raccolta documenti per OCR

- Raccolta di immagini per il rilevamento dei danni ai veicoli

- Raccolta di immagini della targa del veicolo

- Collezione di immagini per interni auto

- Raccolta di immagini con automobilista a fuoco

- Raccolta di immagini legate alla moda

Parliamo

Domande frequenti (FAQ)

DL è un sottocampo di ML che utilizza reti neurali artificiali con più livelli per apprendere schemi complessi nei dati. Il machine learning è un sottoinsieme dell'intelligenza artificiale che si concentra su algoritmi e modelli che consentono alle macchine di apprendere dai dati. I grandi modelli linguistici (LLM) sono un sottoinsieme del deep learning e condividono un terreno comune con l'IA generativa, in quanto entrambi sono componenti del campo più ampio del deep learning.

I modelli linguistici di grandi dimensioni, o LLM, sono modelli linguistici ampi e versatili che vengono inizialmente preaddestrati su dati di testo estesi per cogliere gli aspetti fondamentali del linguaggio. Vengono quindi messi a punto per applicazioni o attività specifiche, consentendo loro di essere adattati e ottimizzati per scopi particolari.

In primo luogo, i modelli di linguaggio di grandi dimensioni possiedono la capacità di gestire un'ampia gamma di attività grazie alla loro vasta formazione con enormi quantità di dati e miliardi di parametri.

In secondo luogo, questi modelli mostrano adattabilità in quanto possono essere messi a punto con dati di addestramento sul campo specifici minimi.

Infine, le prestazioni degli LLM mostrano un miglioramento continuo quando vengono incorporati dati e parametri aggiuntivi, migliorandone l'efficacia nel tempo.

La progettazione dei prompt implica la creazione di un prompt personalizzato per l'attività specifica, ad esempio la specifica della lingua di output desiderata in un'attività di traduzione. Il prompt engineering, d'altra parte, si concentra sull'ottimizzazione delle prestazioni incorporando la conoscenza del dominio, fornendo esempi di output o utilizzando parole chiave efficaci. Il prompt design è un concetto generale, mentre il prompt engineering è un approccio specializzato. Mentre la progettazione rapida è essenziale per tutti i sistemi, l'ingegnerizzazione rapida diventa cruciale per i sistemi che richiedono precisione o prestazioni elevate.

Esistono tre tipi di modelli linguistici di grandi dimensioni. Ogni tipo richiede un approccio diverso alla promozione.

- I modelli linguistici generici prevedono la parola successiva in base alla lingua nei dati di addestramento.

- I modelli ottimizzati per le istruzioni vengono addestrati per prevedere la risposta alle istruzioni fornite nell'input.

- I modelli sintonizzati sul dialogo vengono addestrati per avere una conversazione simile al dialogo generando la risposta successiva.