Il bene più prezioso per le aziende di questi tempi sono i dati. Poiché le organizzazioni e gli individui continuano a generare enormi quantità di dati al secondo, non è sufficiente acquisire i dati. Devi analizzare, trasformare ed estrarre insight significativi dai dati. Eppure, a malapena 37-40% delle aziende analizza i propri dati e 43% dei responsabili delle decisioni nelle aziende IT teme l'afflusso di dati che possono potenzialmente sopraffare la loro infrastruttura dati.

Con la necessità di prendere decisioni rapide basate sui dati e superare le sfide della disparità delle fonti di dati, sta diventando di fondamentale importanza per le organizzazioni sviluppare un'infrastruttura di dati in grado di archiviare, estrarre, analizzare e trasformare i dati in modo efficiente.

È urgente disporre di un sistema in grado di trasferire i dati dalla sorgente al sistema di archiviazione e di analizzarli ed elaborarli in tempo reale. Pipeline di dati AI offre proprio questo.

Cos'è una pipeline di dati?

Una pipeline di dati è un gruppo di componenti che acquisiscono o acquisiscono dati da origini diverse e li trasferiscono in una posizione di archiviazione predeterminata. Tuttavia, prima che i dati vengano trasferiti al repository, vengono sottoposti a pre-elaborazione, filtraggio, standardizzazione e trasformazione.

Come vengono utilizzate le pipeline di dati nel machine learning?

La pipeline denota l'automazione del flusso di lavoro in un progetto ML abilitando la trasformazione dei dati nel modello. Un'altra forma del pipeline di dati per l'IA funziona suddividendo i flussi di lavoro in diverse parti indipendenti e riutilizzabili che possono essere combinate in un modello.

Le pipeline di dati ML risolvono tre problemi di volume, controllo delle versioni e varietà.

In una pipeline ML, poiché il flusso di lavoro è astratto in diversi servizi indipendenti, consente allo sviluppatore di progettare un nuovo flusso di lavoro semplicemente selezionando e scegliendo solo l'elemento particolare necessario mantenendo le altre parti in quanto tali.

Il risultato del progetto, il design del prototipo e modello di formazione sono definiti durante lo sviluppo del codice. I dati vengono raccolti da fonti disparate, etichettati e preparati. I dati etichettati vengono utilizzati per il test, il monitoraggio delle previsioni e la distribuzione nella fase di produzione. Il modello viene valutato confrontando i dati di addestramento e di produzione.

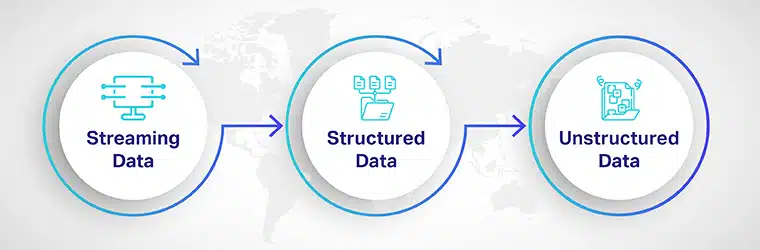

I tipi di dati utilizzati dalle pipeline

Un modello di machine learning viene eseguito sulla linfa vitale delle pipeline di dati. Ad esempio, viene utilizzata una pipeline di dati raccolta dei dati, pulizia, elaborazione e archiviazione dei dati che verranno utilizzati per l'addestramento e il test dei modelli. Poiché i dati vengono raccolti sia dal lato aziendale che da quello del consumatore, potrebbe essere necessario analizzare i dati in più formati di file e recuperarli da diverse posizioni di archiviazione.

Quindi, prima di pianificare il tuo stack di codice, dovresti conoscere il tipo di dati che elaborerai. I tipi di dati utilizzati per elaborare le pipeline ML sono:

Dati in streaming: Il live dati in ingresso utilizzato per l'etichettatura, l'elaborazione e la trasformazione. Viene utilizzato per previsioni meteorologiche, previsioni finanziarie e analisi del sentiment. I dati in streaming di solito non vengono archiviati in un file set di dati o sistema di archiviazione perché viene elaborato in tempo reale.

Dati strutturati: Si tratta di dati altamente organizzati archiviati in data warehouse. Questi dati tabulari sono facilmente ricercabili e recuperabili per l'analisi.

Dati non strutturati: Rappresenta quasi l'80% di tutti i dati generati dalle imprese. Include testo, audio e video. Questo tipo di dati diventa estremamente difficile da archiviare, gestire e analizzare poiché manca di struttura o formato. Le ultime tecnologie, come AI e ML, vengono utilizzate per trasformare i dati non strutturati in un layout strutturato per un uso migliore.

Come creare una pipeline di dati scalabile per addestrare i modelli ML?

Ci sono tre passaggi fondamentali nella creazione di una pipeline scalabile,

Scoperta dei dati: prima che i dati vengano immessi nel sistema, devono essere scoperti e classificati in base a caratteristiche quali valore, rischio e struttura. Poiché è necessaria un'ampia varietà di informazioni per addestrare l'algoritmo ML, Dati dell'IA le piattaforme vengono utilizzate per estrarre informazioni da fonti eterogenee, come database, sistemi cloud e input degli utenti.

Ingestione di dati: L'inserimento automatico dei dati viene utilizzato per sviluppare pipeline di dati scalabili con l'aiuto di webhook e chiamate API. I due approcci di base all'inserimento dei dati sono:

- Inserimento in batch: nell'inserimento in batch, i batch o i gruppi di informazioni vengono acquisiti in risposta a una qualche forma di trigger, ad esempio dopo un po' di tempo o dopo aver raggiunto una dimensione o un numero di file particolare.

- Ingestione di streaming: con l'acquisizione di streaming, i dati vengono inseriti nella pipeline in tempo reale non appena vengono generati, rilevati e classificati.

Pulizia e trasformazione dei dati: Poiché la maggior parte dei dati raccolti non sono strutturati, è importante che vengano puliti, segregati e identificati. Lo scopo principale della pulizia dei dati prima della trasformazione è rimuovere duplicati, dati fittizi e dati corrotti in modo che rimangano solo i dati più utili.

Pre-elaborazione:

In questa fase, i dati non strutturati vengono categorizzati, formattati, classificati e archiviati per l'elaborazione.

Elaborazione e gestione del modello:

In questa fase, il modello viene addestrato, testato ed elaborato utilizzando i dati acquisiti. Il modello viene perfezionato in base al dominio e ai requisiti. Nella gestione del modello, il codice viene archiviato in una versione che aiuta a sviluppare più rapidamente il modello di apprendimento automatico.

Modello di distribuzione:

Nella fase di distribuzione del modello, il file intelligenza artificiale La soluzione viene implementata per l'utilizzo da parte di aziende o utenti finali.

Pipeline di dati: vantaggi

Il pipelining dei dati aiuta a sviluppare e distribuire modelli ML più intelligenti, più scalabili e più accurati in un periodo significativamente più breve. Alcuni vantaggi del pipelining di dati ML includono

Programmazione ottimizzata: La pianificazione è importante per garantire che i tuoi modelli di machine learning funzionino senza problemi. Man mano che il ML aumenta, scoprirai che alcuni elementi nella pipeline ML vengono utilizzati più volte dal team. Per ridurre il tempo di calcolo ed eliminare gli avviamenti a freddo, è possibile pianificare la distribuzione per le chiamate dell'algoritmo utilizzate di frequente.

Tecnologia, framework e indipendenza dal linguaggio: Se utilizzi un'architettura software monolitica tradizionale, dovrai essere coerente con il linguaggio di codifica e assicurarti di caricare contemporaneamente tutte le dipendenze richieste. Tuttavia, con una pipeline di dati ML che utilizza endpoint API, le parti disparate del codice sono scritte in diversi linguaggi e utilizzano i loro framework specifici.

Il principale vantaggio dell'utilizzo di una pipeline ML è la capacità di ridimensionare l'iniziativa consentendo di riutilizzare più volte parti del modello nello stack tecnologico, indipendentemente dal framework o dal linguaggio.

Sfide della pipeline di dati

Scalare i modelli di intelligenza artificiale dal test e dallo sviluppo all'implementazione non è facile. Negli scenari di test, gli utenti aziendali oi clienti possono essere molto più esigenti e tali errori possono essere costosi per l'azienda. Alcune sfide del pipelining dei dati sono:

Sfide di pulizia e preparazione: Oltre alle sfide tecniche del pipelining dei dati, c'è la sfida della pulizia e preparazione dei dati. dati grezzi dovrebbe essere preparato su larga scala e, se l'etichettatura non viene eseguita in modo accurato, può portare a problemi con la soluzione AI.

Sfide organizzative: Quando viene introdotta una nuova tecnologia, il primo grande problema si pone a livello organizzativo e culturale. A meno che non ci sia un cambiamento culturale o le persone non siano preparate prima dell'implementazione, può significare il destino per il Pipeline AI progetto.

La sicurezza dei dati: Quando si ridimensiona il progetto ML, la stima della sicurezza e della governance dei dati può rappresentare un grosso problema. Poiché inizialmente, la maggior parte dei dati sarebbe stata archiviata in un unico luogo; potrebbero esserci problemi con il furto, lo sfruttamento o l'apertura di nuove vulnerabilità.

La creazione di una pipeline di dati deve essere allineata con i tuoi obiettivi aziendali, i requisiti del modello ML scalabile e il livello di qualità e coerenza di cui hai bisogno.

Impostazione di una pipeline di dati scalabile per modelli di apprendimento automatico può essere impegnativo, dispendioso in termini di tempo e complesso. Shaip rende l'intero processo più semplice e privo di errori. Con la nostra vasta esperienza nella raccolta dei dati, collaborare con noi ti aiuterà a fornire più velocemente, ad alte prestazioni, integrato, e soluzioni di apprendimento automatico end-to-end a una frazione del costo.